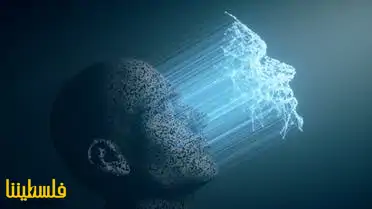

إن تقنية Deepfakes هي الأكثر استخدامًا في مجال الذكاء الاصطناعي في الجريمة والإرهاب، وذلك وفقًا لتقرير جديد من كلية لندن الجامعية.

حدد فريق البحث في كلية لندن لأول مرة 20 طريقة مختلفة لاستخدام المجرمين الذكاء الاصطناعي على مدى السنوات 15 المقبلة، ثم طلبوا من 31 خبيرًا في الذكاء الاصطناعي تصنيفهم حسب المخاطر، بناءً على إمكانية الضرر والأموال التي يمكنهم كسبها وسهولة استخدامها ومدى صعوبة إيقاف المجرمين.

إن تقنية Deepfakes التي يعتمدها المجرمون لإنشاء مقاطع فيديو بواسطة الذكاء الاصطناعي لأشخاص حقيقيين يقومون بقول أشياء خيالية حصلت على المرتبة الأولى لسببين رئيسيين:

أولهما: يصعب تحديدهم ومنعهم، حيث لا تزال طرق الكشف الآلي غير موثوق بها، كما أن تقنية Deepfakes تتحسن في خداع العيون البشرية، حيث أدت مسابقة حديثة على فيسبوك لاكتشافها باستخدام الخوارزميات إلى اعتراف الباحثين بأنها مشكلة كبيرة لم يتم حلها.

ثانيهما: يمكن استخدام تقنية Deepfakes في مجموعة متنوعة من الجرائم والأفعال السيئة، بدءًا من تشويه سمعة الشخصيات العامة، إلى الحصول على الأموال من الجمهور عن طريق انتحال هوية الأشخاص. ففي هذا الأسبوع فقط، انتشر مقطع فيديو بشكل فيروسي لنانسي بيلوسي تبدو فيه مخمورة للغاية، كما ساعدت تقنية Deepfakes المجرمين على سرقة ملايين الدولارات.

بالإضافة إلى ذلك، يخشى الباحثون من أن هذه التقنية ستجعل الناس لا يثقون في الأدلة السمعية والبصرية، حيث سيحدث ذلك ضررًا مجتمعيًا كبيرًا.

قال مؤلف الدراسة الدكتور (Matthew Caldwell): “كلما زادت حياتنا على الإنترنت زادت المخاطر، وعلى عكس العديد من الجرائم التقليدية، يمكن بسهولة مشاركة الجرائم في العالم الرقمي وتكرارها وكذلك بيعها، مما يسمح بتسويق التقنيات الإجرامية وتقديم الجريمة كخدمة، وهذا يعني أن المجرمين قد يكونون قادرين على الاستعانة بمصادر خارجية في أكثر الجوانب تحديًا لجرائمهم القائمة على الذكاء الاصطناعي.

حددت الدراسة أيضًا خمسة تهديدات رئيسية أخرى بجرائم الذكاء الاصطناعي: المركبات التي بدون سائق كأسلحة، والتصيد الاحتيالي، وجمع البيانات عبر الإنترنت للابتزاز، والهجمات على الأنظمة التي يسيطر عليها الذكاء الاصطناعي، والأخبار المزيفة.

لكن الباحثين لم يكونوا قلقين بشكل مفرط من (burglar bots) التي تدخل المنازل من خلال صناديق الرسائل ولوحات القطط، حيث يسهل التقاطها. كما صنفوا المطاردة بمساعدة الذكاء الاصطناعي على أنها جريمة ذات قلق منخفض، على الرغم من أنها ضارة للغاية للضحايا؛ لأنها لا تستطيع العمل على نطاق واسع.

كما أن الباحثين كانوا أكثر قلقًا بشأن مخاطر تقنية Deepfakes، حيث إن هذه التكنولوجيا كانت تستحوذ على العناوين منذ ظهور المصطلح على (Reddit) في عام 2017، ولكن لم يتم تحقيق سوى القليل من المخاوف حتى الآن، ومع ذلك، يعتقد الباحثون أنه من المقرر أن تتغير الأمور مع تطور التكنولوجيا، ويصبح الوصول إلى تقنية التزييف العميق أكثر سهولة.

المصدر

تعليقات القرّاء

التعليقات المنشورة لا تعبر عن رأي الموقع وإنما تعبر عن رأي أصحابها